Stefano Scarani estrena “Calaveras – First vision of death” en el

XVIII FESTIVAL PUNTO DE ENCUENTRO / Madrid

Stefano Scarani estrena “Calaveras – First vision of death” en el

XVIII FESTIVAL PUNTO DE ENCUENTRO / Madrid

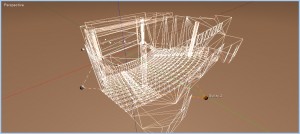

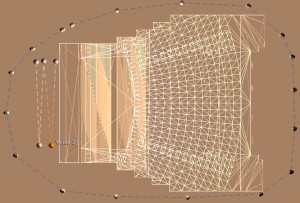

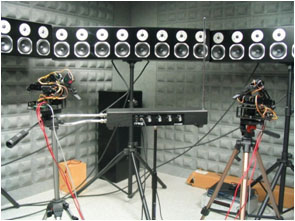

El pasado 30 de septiembre se emitió en el programa Polifutur de la Radio Televisión de la Universidad Politécnica de Valencia un nuevo reportaje sobre el Título de Música Electrónica y Electroacústica, Interactividad y Vídeo Creación. En él se describe cómo surge el nuevo Título, sus objetivos, su estructuración y contenidos, y otros detalles interesantes como la descripción de la sala de Wave Field Synthesis (WFS) del Instituto de Telecomunicaciones y Aplicaciones Multimedia de la UPV. Dicha sala consta de 96 altavoces y un sistema software para posicionar las fuentes sonoras virtuales en el espacio, tanto dentro como fuera del entorno de los altavoces. Dicho sistema reproduce las ondas sonoras reales que se producirían si las fuentes sonoras virtuales se situaran en las posiciones asignadas por el operador del software, permitiendo también el movimiento de las fuentes en tiempo real.

Os recordamos que la preinscripción para el Título de Música Electrónica y Electroacústica, Interactividad y Vídeo Creación está abierta hasta el 15 de diciembre y las clases empezarán el 9 de enero. Para más información podéis acceder a la dirección

http://musicaelectronica.blogs.upv.es/gestion-organizativa/inscripcion/

[youtube]zPELHhEYQk0[/youtube]

Ayudándote a crear

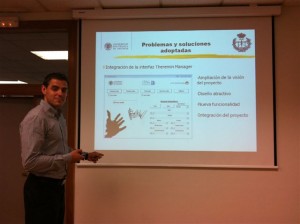

El pasado 27 de septiembre se presentó un nuevo proyecto del Instituto de Telecomunicaciones y Aplicaciones Multimedia (iTEAM) de la UPV relacionado con sistemas de audio, dando a conocer una forma nueva para componer y producir música y efectos sonoros para los sistemas envolventes del futuro. La herramienta presentada fue desarrollada por el ingeniero Jose Á. Lausuch y dirigida por el Dr. José Javier López, profesor del Título de Música Electrónica y Electroacústica, Interactividad y Vídeo Creación .

El objetivo del proyecto surge de la necesidad hasta la fecha de producir tantas masterizaciones de audio como configuraciones de altavoces se desee obtener para el audio de un audiovisual. El productor o ingeniero de sonido debía generar dos mezclas diferentes si se deseaba utilizar dos sistemas envolventes diferentes (5.1 y 7.1, por ejemplo). Con la nueva  herramienta desarrollada, el compositor o productor se limita a posicionar las fuentes sonoras en el espacio, con la posibilidad de movimiento a lo largo del tiempo. Una vez elegido el sistema de reproducción (estéreo, 5.1, 7.1, etc.), mediante un procesado interno se genera la señal correspondiente para cada altavoz de forma automática.

herramienta desarrollada, el compositor o productor se limita a posicionar las fuentes sonoras en el espacio, con la posibilidad de movimiento a lo largo del tiempo. Una vez elegido el sistema de reproducción (estéreo, 5.1, 7.1, etc.), mediante un procesado interno se genera la señal correspondiente para cada altavoz de forma automática.

El proyecto usa diferentes tecnologías. Por un lado se ha creado un Plug-in VST que puede ser abierto en secuenciadores como Cubase o Nuendo y que realiza ciertas funciones específicas. Por otro lado, se utiliza un Driver ASIO virtual que lleva la señal de audio de salida por paquetes Ethernet en lugar de emitirlos por una tarjeta de sonido. Mediante una interfaz gráfica es posible posicionar las fuentes sonoras en el espacio tridimensional y en el tiempo. Toda esta información es recogida por un motor de procesado que realiza los cálculos necesarios para llevar la señal de salida al sistema de altavoces envolvente con el efecto deseado de las fuentes sonoras en movimiento.

La nueva herramienta abre un nuevo abanico de posibilidades para la producción sonora de películas. Con la combinación de imagen 3D y un sonido envolvente más elaborado que el actual se podrá conseguir una sensación de realismo mucho mayor en las salas de cine, con la ventaja de que la aplicación desarrollada puede utilizarse para cualquier sistema de reproducción envolvente, tanto los X.1 como los de nueva generación, como es el caso de el Wave Field Synthesis (WFS).

Ayudándote a crear

Las fechas y horarios definitivos han sido ya publicados en el apartado Fechas y Horarios (actualizado):

Las clases se desarrollarán desde el 9 de enero al 15 de junio de 2012. La docencia será SEMIPRESENCIAL, dependiendo de cada materia. En aquellas clases con posibilidad de ser no presenciales el alumno podrá optar también por asistir de forma presencial si lo desea. Para las clases no presenciales será necesario diponer de conexión a internet y un navegador, con el cual el alumno recibirá el vídeo de la clase en directo a través de internet.

Las asignaturas tendrán una duración de 6 semanas excepto las dos últimas asignaturas, de 2 créditos, que se concentrarán en 2 semanas cada una. La carga lectiva habitual será de diez horas semanales, que puede ser inferior en algún periodo de impartición del título dependiendo de las asignaturas seleccionadas por el alumno.

El HORARIO será de 16 a 21 horas.

Las AULAS de impartición serán:

Las FECHAS DEFINITIVAS son:

1. Fundamentos Tecnológicos de Audio y Vídeo (LUNES): CFP enero 9, 16 y 23; LIS enero 30, febrero 6 y 13.

2. Fundamentos de Música e Introducción al Arte Contemporáneo Sonoro y Visual (VIERNES): CFP enero 13, 20 y 27, febrero 3, 10 y 17.

3. Música y Tecnología, Taller de construcción de un theremin (JUEVES): CFP enero 12, 19 y 26, febrero 2; LIS febrero 9 y 16.

4. Síntesis de sonido y efectos digitales (VIERNES excepto el martes 13 de marzo por las festividades de Fallas): LI VI viernes febrero 24, marzo 2 y 9, martes 13, viernes 23 y 30.

5. Programación en Max/MSP (MIÉRCOLES): LI VI febrero 22 y 29; marzo 7, 14, 21 y 28.

6. Videoarte Interactivo: Interacción entre Personas, Imágenes y Sonidos (VIERNES excepto el miércoles 4 de abril por las festividades de Semana Santa): LIS abril miércoles 4, viernes 20 y 27, mayo 4, 11 y 18.

7. Interfaces: Interacción entre Personas, Imágenes y Sonido (JUEVES excepto el martes 3 de abril por las festividades de Semana Santa): CFP abril 3, 19 y 26; LIS mayo 3, 10 y 17.

8. Ableton Live (concentrado en dos semanas, lunes y jueves): LI VII mayo 21, 24, 28 y 31.

9. Tecnología y sonido, movimiento, espacio e imagen. Últimas tendencias, direcciones y territorios (concentrado en dos semanas, jueves y viernes): CFP 7, 8, 14 y 15 junio.

El alumno elegirá un tutor para su proyecto final de título, que realizará de forma no presencial y deberá presentar para su evaluación una vez finalizadas las clases. Se celebrará un evento final de la primera edición del título en noviembre-diciembre de 2012 donde se presentarán los mejores trabajos.

Performance con danza por Verde María e interpretación de Hang por Osvaldo Jorge

Performance con danza por Verde María e interpretación de Hang por Osvaldo Jorge

sobre vídeo arte interactivo realizado para la obra Magush del compositor

Saúl Gómez (J. Rodrigo) y la ingeniero Belén Ceñal (UPV)

Ayudándote a crear

No podemos continuar con nuestra sección de noticias sin hacer mención de Magush, una obra que aúna música, danza e imagen interactivas y cuyas imágenes pueblan nuestra web. Magush se estrenó el 23 de junio de 2010 en el Salón de actos del Club Diario Levante dentro del ciclo Primavera Electroacústica 2010 de Valencia, organizado por la Asociación de Música Electroacústica de España (AMEE).

No podemos continuar con nuestra sección de noticias sin hacer mención de Magush, una obra que aúna música, danza e imagen interactivas y cuyas imágenes pueblan nuestra web. Magush se estrenó el 23 de junio de 2010 en el Salón de actos del Club Diario Levante dentro del ciclo Primavera Electroacústica 2010 de Valencia, organizado por la Asociación de Música Electroacústica de España (AMEE).

Magush, título de la pieza, proviene del antiguo persa y significa “magia”, motivo principal de esta pieza de música contemporánea compuesta por Saúl Gómez Soler, cuyos efectos visuales interactivos fueron programados por Belén Ceñal, en una colaboración entre el Conservatorio Superior  de Música Joaquín Rodrigo y la ETSI de Telecomunicaciones de la Universidad Politécnica de Valencia. El trabajo fue dirigido respectivamente por el Catedrático de Composición de Música Electroacústica Gregorio Jiménez, y el profesor de la ETSIT Jorge Sastre. Esta obra se realizó en el marco de la colaboración tecnológico musical que el grupo Ars Aetherea de la UPV está llevando a cabo con el compositor Gregorio Jiménez.

de Música Joaquín Rodrigo y la ETSI de Telecomunicaciones de la Universidad Politécnica de Valencia. El trabajo fue dirigido respectivamente por el Catedrático de Composición de Música Electroacústica Gregorio Jiménez, y el profesor de la ETSIT Jorge Sastre. Esta obra se realizó en el marco de la colaboración tecnológico musical que el grupo Ars Aetherea de la UPV está llevando a cabo con el compositor Gregorio Jiménez.

La pieza fue interpretada por el percusionista Joan Pons al frente del vibráfono y un pequeño set de instrumentos, la soprano Tania Durán y la bailarina Cristina Maestre. Durante la pieza, las tres artes música, danza e imagen interactuaron entre sí creando un conjunto armónico y vanguardista donde las imágenes respondían activamente a la música y danza. Con el fin de crear un vínculo entre el espectador y la temática la obra poseía citas a “Alicia en el país de las maravillas”, “El mago de Oz” y musicalmente era posible intuir motivos de “El aprendiz de brujo” de Paul Dukas.

Para la realización del proyecto se utilizó el programa Max/MSP para procesado de audio y el VVVV para procesado de vídeo en tiempo real. El resultado es una fusión de música, danza y tecnología compuestas para sorprender y sumerger al espectador en la temática de la magia.

Para la realización del proyecto se utilizó el programa Max/MSP para procesado de audio y el VVVV para procesado de vídeo en tiempo real. El resultado es una fusión de música, danza y tecnología compuestas para sorprender y sumerger al espectador en la temática de la magia.

Las imágenes que se presentan en nuestra web corresponden a la performance realizada por la bailarina Verde María y el intérprete de Hang Osvaldo Jorge en la ETSIT en septiembre de 2010 sobre los efectos de vídeo arte interactivo realizados para Magush.

Ayudándote a crear

El pasado 28 de junio se presentó en la ETSI de Telecomunicación de la UPV el proyecto fin de carrera “Instrumento Musical Virtual Mediante Seguimiento de Color” realizado por el ingeniero David Simarro en el Instituto de Telecomunicaciones y Aplicaciones Multimedia (iTEAM) y dirigido por los profesores Dr. Jorge Sastre y Dr. Carlos Hernández.

El pasado 28 de junio se presentó en la ETSI de Telecomunicación de la UPV el proyecto fin de carrera “Instrumento Musical Virtual Mediante Seguimiento de Color” realizado por el ingeniero David Simarro en el Instituto de Telecomunicaciones y Aplicaciones Multimedia (iTEAM) y dirigido por los profesores Dr. Jorge Sastre y Dr. Carlos Hernández.

El proyecto es la continuación de un proyecto mayor en el que se ha desarrollado una interfaz mediante cámara de vídeo basada en seguimiento de color para controlar diferentes aspectos del sonido. Inicialmente el proyecto se basó en utilizar la interfaz para imitar el  funcionamiento de un theremin virtual. Su principal desarrollador desde el inicio en 2009 fue el alumno Eric Bäckert, de la Hochschule für Technik und Wirtschaft (HTW) de la Universidad de Ciencias Aplicadas de Dresden (Alemania). Eric realizó su proyecto con una beca en la UPV, dirigido por la profesora del HTW Dr. Kristina Kelber y el profesor Dr. Carlos Hernández, y se encargó de enlazar el módulo de generación de sonido con el programa básico de seguimiento de color, realizado por Emanuel Aguilera, investigador del iTEAM.

funcionamiento de un theremin virtual. Su principal desarrollador desde el inicio en 2009 fue el alumno Eric Bäckert, de la Hochschule für Technik und Wirtschaft (HTW) de la Universidad de Ciencias Aplicadas de Dresden (Alemania). Eric realizó su proyecto con una beca en la UPV, dirigido por la profesora del HTW Dr. Kristina Kelber y el profesor Dr. Carlos Hernández, y se encargó de enlazar el módulo de generación de sonido con el programa básico de seguimiento de color, realizado por Emanuel Aguilera, investigador del iTEAM.

En la fase desarrollada por David, entre otras actividades, se amplió este funcionamiento para controlar otros aspectos como la intesidad del vibrato mediante la cercanía de las manos a la cámara, o para que los objetos que el sistema sigue pudieran ser elementos diferentes de las manos. También se incorporaron sistemas de grabación y calibración para poder grabar y reproducir interpretaciones a voluntad.

que el sistema sigue pudieran ser elementos diferentes de las manos. También se incorporaron sistemas de grabación y calibración para poder grabar y reproducir interpretaciones a voluntad.

El proyecto tuvo repercusión mediática apareciendo en diversas cadenas de televisión y está prevista la continuación del mismo para incorporar nuevas funcionalidades a la interfaz virtual.  El tribunal del proyecto, presidido por la profesora Dr. Carmen Bachiller, le otorgó la máxima calificación por unanimidad.

El tribunal del proyecto, presidido por la profesora Dr. Carmen Bachiller, le otorgó la máxima calificación por unanimidad.

Otros proyectos han sido desarrollados por alumnos de la HTW en la UPV como por ejemplo el “Robot-Theremin”, una aplicación de interés docente en la que se desarrolló un sistema de lectura de partituras que eran interpretadas sobre un theremin por dos brazos robot. Este proyecto tuvo varias fases desde 2008, y fue dirigido por la Dr. K. Kelber y el Dr. C. Hernández y realizado en la UPV por Alfred Reisner, Florian Fischer y Andreas Büttner, alumnos del HTW. Dicho proyecto dio lugar al artículo “Digital Signal Processing Applied to Musical Hyper Instruments” en el congreso International Technology, Education and Development Conference INTED 2010.

“Digital Signal Processing Applied to Musical Hyper Instruments” en el congreso International Technology, Education and Development Conference INTED 2010.

Ayudándote a crear